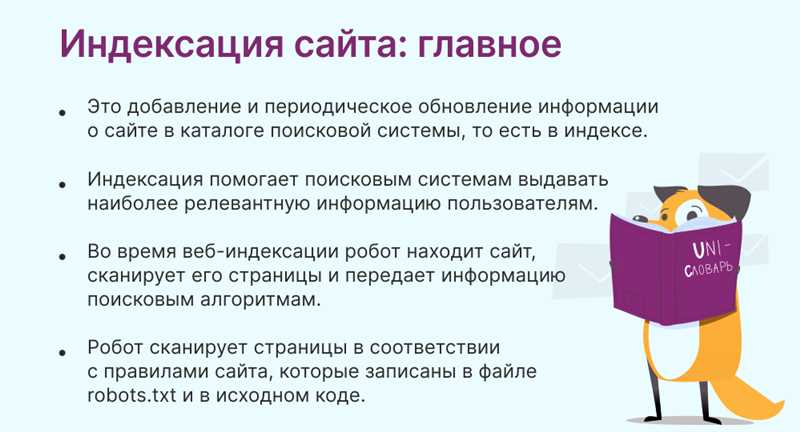

Индексация сайта поисковыми системами – важный шаг на пути к его успешному продвижению и привлечению аудитории. Однако, существуют ситуации, когда владельцы сайтов желают ограничить доступ поисковым роботам к определенной части сайта или закрыть сайт полностью от индексации.

Такие меры могут быть необходимы в таких случаях, как тестирование новых страниц, временное прекращение работы сайта, разработка и тестирование новых функций, учет особенностей правового регулирования в отношении коммерческой информации. В данной статье будут рассмотрены практические решения по закрытию сайта или его части от индексации, а также советы по их использованию.

Первым методом для закрытия части сайта от индексации является использование файла robots.txt. Этот текстовый файл позволяет указать поисковым системам какие области сайта они могут индексировать, а какие нет. Для блокировки индексации определенных директорий или файлов необходимо добавить соответствующие записи в файл robots.txt.

Вторым методом является использование мета-тега noindex. Данный тег указывает поисковым системам, что страница не должна индексироваться и не должна включаться в выдачу. Мета-тег noindex можно вставить в разметку каждой страницы, которую нужно закрыть от индексации.

Файл robots.txt

Преимущества использования файла robots.txt очевидны – он позволяет более гибко управлять тем, что поисковые системы могут и не могут индексировать на вашем сайте.

Синтаксис файл robots.txt

Файл robots.txt состоит из набора правил, каждое из которых состоит из двух основных компонентов – «User-agent» и «Disallow».

| User-agent: | Указывает на поискового робота, которому применяется данное правило. Например, «*» — для всех роботов, или «Googlebot» — специфично для Google. |

| Disallow: | Определяет страницы или директории, которые следует исключить из индексации. Например, «/private/» запрещает доступ к каталогу «/private/». |

Файл robots.txt также позволяет включать комментарии, которые начинаются с символа «#» или «;» и являются информационными подсказками для вебмастеров или разработчиков.

Важно отметить, что файл robots.txt не является защитой от нежелательного индексирования и не ограничивает доступ к страницам. Но в то же время, некоторые поисковые системы и роботы уважительно относятся к указаниям в файле и следуют правилам, которые в нем указаны. Однако, не все роботы обязательно соблюдают такие правила. Поэтому важно использовать и другие методы контроля за индексацией, такие как мета-тег «noindex» или парольная защита.

Использование мета-тега noindex

Применение мета-тега noindex осуществляется путем его размещения в секции head каждой страницы, которую нужно исключить из поискового индекса. Код тега выглядит следующим образом:

<meta name="robots" content="noindex">

При размещении данного тега на странице, поисковые роботы поисковых систем будут игнорировать ее при индексации и не отображать ее в поисковой выдаче. Однако, стоит отметить, что этот тег не является абсолютной гарантией от индексации. Некоторые поисковые системы могут проигнорировать данный тег или его наличие может быть причиной возникновения проблем с индексацией других страниц сайта.

Установка директивы X-Robots-Tag в заголовках HTTP

Для закрытия сайта или его части от индексации поисковыми системами можно использовать директиву X-Robots-Tag. Эта директива может быть установлена в заголовках HTTP и указывает поисковым роботам, как обрабатывать содержимое сайта. Она предоставляет различные директивы, позволяющие контролировать индексацию и доступность страниц.

Применение директивы X-Robots-Tag в заголовках HTTP имеет несколько преимуществ. Во-первых, она действует независимо от файла robots.txt, то есть даже если файл robots.txt отсутствует или некорректен, директива X-Robots-Tag все равно будет применяться. Во-вторых, она позволяет более гибко настраивать поведение поисковых систем в отношении индексации конкретных URL-адресов.

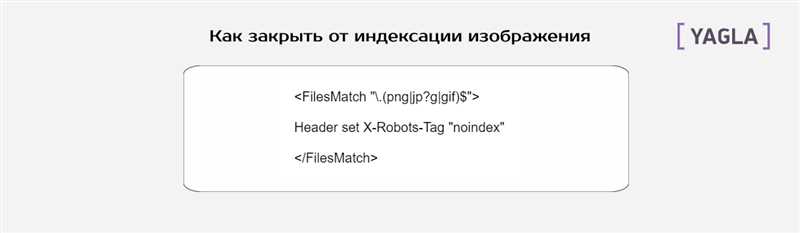

Для установки директивы X-Robots-Tag в заголовках HTTP необходимо внести соответствующие изменения в настройки сервера или CMS (системы управления контентом). Например, можно добавить следующий код в файл .htaccess:

<IfModule mod_headers.c> Header set X-Robots-Tag "noindex, nofollow" </IfModule>

В этом примере директива X-Robots-Tag установлена в значение «noindex, nofollow», что означает запрет индексации и следования ссылкам на страницу. Вы можете настроить эту директиву согласно вашим потребностям, выбрав нужные значения.

Важно отметить, что установка директивы X-Robots-Tag требует некоторых знаний в области настройки сервера или CMS. Если вы не уверены в своих навыках, рекомендуется проконсультироваться с веб-разработчиком или специалистом по SEO.

Наши партнеры: